Das Erkennen des Faktischen ist schwer, im Besonderen, wenn die Ereignisse nicht im Umfeld der selbstevidenten Beobachtung liegt. Trends können recht klar über positive oder alarmierende Entwicklungen Aussagen machen. Dazu sind aber verlässliche Faktensammlungen, Aufbereitungen der deskriptiven Statistik und Analysen unter Nutzung der analytischen Statistik erforderlich. Ansonsten wird gerne mit ‚gefühlten‘ Realitäten und Erwartungen anstelle von Fakten gesprochen. Und dann sind derartige Erkenntnisse weitgehend wertlos.

Nun ist allerdings ein gefälschtes Zitat in aller Munde, das Goebbels Churchill untergeschoben hat:

Ich glaube nur der Statistik, die ich selbst gefälscht habe.

Dies wird in der Regel pauschal und wohlfeil von jenen vorgetragen, die mit einer missliebigen Statistik konfrontiert werden. Und zwar oft ohne Indizien, warum die Statistik vorgebliche gefälscht sei. So gibt es in der Tat nicht selten manipulativ veränderte Statistiken oder Analysen, die echte Statistiken verzerrend verwenden. Politische Macht hat oft jener, der die Deutungshoheit über die Realität hat … oder die Deutungshoheit hat der, der über politische Macht verfügt. Die Realität bleibt damit oft genug auf der Strecke. Wir aber wollen der Realität ins Auge blicken und uns weder von Manipulatoren vorführen lassen, noch von wohlmeinenden Zeitgenossen, die selbst eine Täuschung aufgesessen sind, noch von eigenem Wunschdenken. Denn nur bei robuster Faktenkenntnis und zutreffenden Analysen können wir sachgerechte Urteile treffen. Um dieses Ziel zu erreichen – oder sich zumindest diesem zu nähern, müssen wir uns über einiges im Klaren werden.

Die Pauschalkritik an Statistiken ist vor allem dann statthaft, wenn sie als eine Grundskepsis verstanden wird. Denn wenn wir wissen, dass nicht jede Statistik per se vertrauenswürdig ist, werden wir vor allem bei unerwarteten Aussagen den Zweifel anbringen. Ebenso sollte man aber entgegen der menschlichen Natur auch jene Statistiken bezweifeln, die der eigenen Erwartung entsprechen, denn sonst würden nur falsche Ansichten verfestigt.

Bevor wir aber das methodische Handwerkszeug schärfen, um Statistiken gewinnbringend nutzen zu können und von Manipulationen zu unterscheiden, komme ich zu einer Fallstudie

Das Umweltbundesamt und die Medienpolitik

Das UBA veröffentlicht viele Informationen. Als staatliche Institution würde man erwarten, dass man hier hohe Qualitätsstandards und verlässliche Faktizität geliefert bekommt. Im Besonderen geht es hier auch nicht um Meinungsumfragen oder andere Statistiken der Sozialwissenschaften, die viel leichter dehnbar sind, sondern um vermeintlich harte Fakten. Ich habe den Bericht

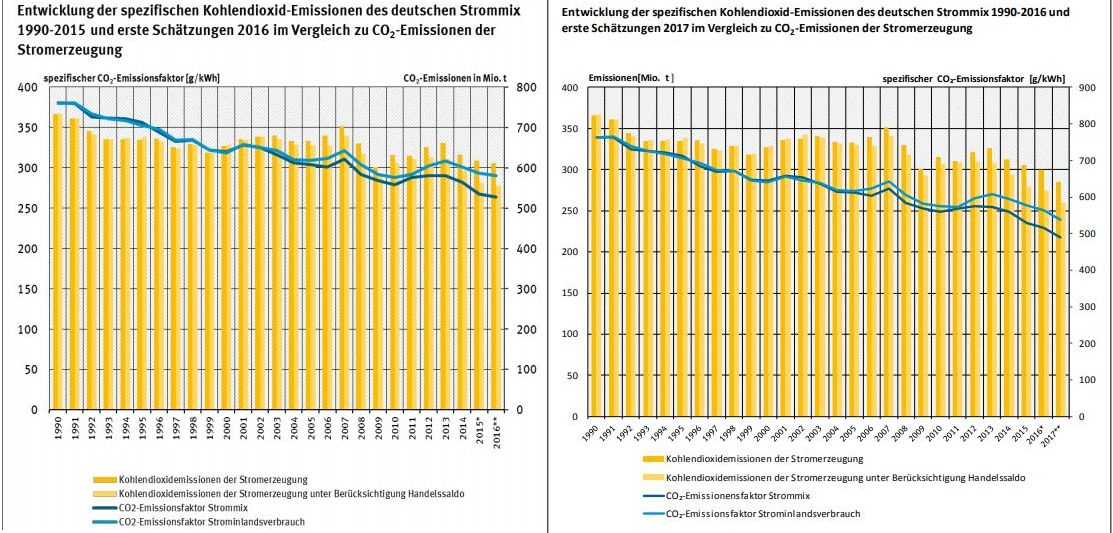

Entwicklung der spezifischen Kohlendioxid-Emissionen des deutschen Strommix in den Jahren 1990 – 2016 und dessen Fortschreibung für das nächste Jahr verglichen und analysiert.

Notwendigerweise muss sich die Analyse auch in technische Details vertiefen. Ich entschuldige mich bei den Lesern, die dies langweilt, aber der Teufel steckt zuweilen im Detail.

Ein Bild sagt angeblich mehr als 1000 Worte.

Beide Grafiken wirken übersichtlich, professionell und ansprechend. Die Wirkung allerdings ist psychologisch eine andere. Der oberflächliche Beobachter meint im linken Bild, der älteren Version, eher eine Stagnation zu erkennen. Vor allem die hellblaue Linie bleibt auf einem hohen Niveau. Diesen Eindruck wollte unbedingt vermeiden und erreicht, dass im linken Bild, der neueren Version der Eindruck vermittelt wird, dass es zu einer deutlichen Reduktion kommt. Eine gewünschte Entwicklung wird dokumentiert.

Wie wurde das erreicht? Hier sind folgende Bearbeitungen erkennbar:

- Die Y1 und Y2 Achsentitel wurden korrigiert.

- Die Skalierung wurde geändert zugunsten eines anderen Eindrucks

- Die zugrunde liegenden Daten wurden manipuliert.

Zu letztem Punkt unten mehr. Zunächst zur sachlichen Klärung. Es werden 4 Zahlenreihen abgebildet:

- Kohlendioxidemissionen der Stromerzeugung

- Kohlendioxidemissionen der Stromerzeugung unter Berücksichtigung Handelssaldo

- CO₂-Emissionensfaktor Strommix (unter Berücksichtigung Handelssaldo)

- CO₂-Emissionsfaktor Strominlandsverbrauch

Die erste Frage darin mag den unkundigen Leser verwirren, denn die beiden Werte driften in jüngerer Zeit auseinander. Das UBA bezieht sich auf Bilanzierungsvorgaben des IPCC. Hier auf Seite 2.43

The inventory compiler should confirm that gross carbon supply in the Reference Approach has been adjusted for fossil fuel carbon from imported or exported non-fuel materials in countries where this is expected to be significant.

Also ist der Handelsbilanz-Saldo entsprechend auszuweisen. Wie kann es aber zu einem auseinanderdriften der Werte kommen?

Zunächst auf Seite 4:

Deutschland weist seit dem Jahr 2003 beim Stromexport einen Überschuss auf, der über die letzten Jahre erheblich an Bedeutung gewonnen und im Jahr 2017 mit 55 TWh einen neuen Höchststand erreicht hat. Daher wird der Einfluss des Stromhandelssaldos auf den Strommix seit 2013 um eine zusätzliche Ausweisung des Emissionsfaktors für den Strominlandsverbrauch ergänzt. Gleichzeitig wird deutlich, dass ein steigender Anteil der CO2-Emissionen der Nettoausfuhr von Strom zuzurechnen ist.

Die Zunahme des Außenhandelsüberschusses des Stromes zwischen 2012 und 2017 um fast 32 Mrd. kWh ist wesentlich stärker als die Steigerung der Bruttostromerzeugung im gleichen Zeitraum um ca. 25 Mrd. kWh.

Das erklärt zwar die absoluten Differenzen der Kohlendioxidemissionen der Stromerzeugung, aber nicht die der CO₂-Emissionensfaktoren, denn die sind eigentlich volumenneutral.

Die Erklärung auf Seite 11 irritiert: Man hat einfach den im Saldo exportierten Strom abgezogen – Was sollte denn dann der Inlandverbrauchsfaktor bedeuten? Es macht nur dann Sinn, wenn man davon ausgeht, dass es sich um eine Überproduktion handelt, die man eben einfach entsorgen muss. In der Tat sind die Export-Preise zuweilen Negativ, aber im Mittel deutlich unter den EEG-Garantiepreisen, die die Verbraucher im Inland zu zahlen haben.

Zu den Zahlenmanipulationen: Im Vergleich der beiden Dokumente fällt auf, dass nahezu alle Zahlen rückwirkend geändert wurden. Also auch die Zahlen seit 1990, die nicht mit dem Vermerk ‚vorläufig‘ gekennzeichnet wurden. Das Dokument gibt eine knappe Erklärung auf Seite 4:

Änderungen durch Neuberechnungen der Quellen (Energiebilanzen, Bruttostromerzeugung, Emissionsfaktoren) werden – soweit sie zum Zeitpunkt der Aktualisierung veröffentlicht waren – berücksichtigt.

Eine Aktualisierung von Emissionsfaktoren in den Treibhausgasinventaren bedingt Veränderungen im Bereich der Emissionen aus der Stromerzeugung und eine Aktualisierung im Bereich der erneuerbaren Energien in der Bruttostromerzeugung hat Veränderungen im Stromverbrauch für den deutschen Strommix zur Folge.

Im Grunde aber erklärt die nicht, warum die Änderungen der Daten für 1990 und in den Folgejahren im Jahr 2018 vorgenommen wurden. Gemeinhin würde man annehmen, dass Zahlen, die nicht mit Vorläufig oder Geschätzt vermerkt sind, rückwirkend auch nicht mehr geändert werden. Diese Änderungen finden sich aber flächendeckend und mit einer eindeutigen Tendenz: Die Vergangenheit wurde tendenziell schlechter gemacht, die Gegenwart geschönt. Es entsteht der Eindruck, dass die gewollten Erfolge mit gewisser Skrupellosigkeit einfach hinein manipuliert worden sind und das derartige Praktiken auch ansonsten zum Einsatz kommen.

Wie stabil ist die Vergangenheit?

Rückwirkende Änderungen der Basisdaten werden oft als Homogenisierung oder Korrekturen bezeichnet. Man meint, z.B. mögliche Messfehler durch plausibilitätsprüfungen heraus rechnen zu können. Dies mag in einzelfällen auch nachvollziehbar und hinreichend begründet sein, aber z.B. bei den weltweiten Temperaturaufzeichnungen finden rückwirkende Basisdatenänderung so breit und so stark tendenziell ab, das man ganz andere Motive hinter der Vergangenheitsveränderung vermuten muss.

Zu guter Letzt weiß man gar nicht mehr, was nun die Realität ist und was Wunschvorstellung. Die Glaubwürdigkeit des Berichts ist dahin.

Nun hat dies aber auch einen philosophischen Aspekt: Ist die Vergangenheit wirklich fix und in das Erz der Zeit gegossen? Oder fließt die Vergangenheit in deren aktueller Wahrnehmung? Wenn man also im Jahr 1850 eine bestimmte Temperatur gemessen hat, heute aber der Ansicht ist, dass es sich um einen Fehler handelte, der korrigiert werden müsste: Was ist nun Wahrheit? Diese Frage erweist sich als schwieriger als zunächst gedacht. Natürlich könnte es sein, dass tatsächlich damals ein Messfehler vorlag, der mit heutigen Methoden zutreffend korrigiert werden könnte. Ebenso kann es sein, das man mittels jener ‚Korrektur‘ die Realität nicht zutreffend beschreibt, sondern erst eine alternative Vergangenheit erst erzeugt.

Meine Vorstellung bleibt, dass es eine Realität gibt, die sich zwar unterschiedlich deuten lässt, die aber von einer Absolutheit gekennzeichnet ist und sich nicht beliebig verändern lässt. Selbiges trifft dann für die Vergangenheit zu. Fakten bleiben Fakten. Die Ansicht, dass eine reale Vergangenheit an Bedeutung gegen eine wahrgenommene Vergangenheit verliert halte ich für gefährlich. Denn die Sicht auf die Vergangenheit ist oftmals entscheidend für die Analyse der Gegenwart und der Maßnahmen, die heute getroffen werden.

Allerdings gibt es auch überzeitliche Narrative, die sich gar nicht an eine reale Vergangenheit orientiert sind. Ich spreche von Mythen und Archetypen (im Sinn von C.G. Jung). In religiösen Erzählungen werden häufig Dinge behauptet, die sich so wohl kaum zugetragen haben. Dennoch sind diese Geschichten offensichtlich wirkmächtig. Aber sind sie deswegen auch unwahr? Ist historische Wahrheit das Hauptkriterium für Wahrheit einer Erzählung? Oder sind diese vielleicht lediglich eine Metapher, die einen wahren Sachverhalt in eine verstehbare Form bringt?

Unabhängig davon, ob man dem Mythos auch eine möglichen Wahrheitswert jenseits der Realhistorie zubilligt, wird die Vermengung des Mythos mit der Änderung von Beobachtungsdaten einer statistischen Auswertung skurril.

Die Regeln der Statistik … und deren Nichtbeachtung

Tatsächlich ist aber Statistik eine seriöse Wissenschaft, genauer: Ein Teilgebiet der Mathematik. Hier werden nicht einfach daten gesammelt und visualisiert, sondern mittels klarer Regeln gezeigt, wann ein Ergebnis signifikant ist, oder wie groß eine Stichprobe sein muss, um repräsentativ zu sein. In der analytischen Statistik sind sehr viele Testverfahren entwickelt worden, die hier zuverlässige Ergebnisse liefern kann. Mittels Varianzanalysen lassen sich unterschiedliche Faktoren trennen. Warum aber weiß der gewöhnliche Bürger so wenig darüber? Es liegt weniger an der Bildung der Statistik-Rezipienten, sondern an der Nichtanwendung jener Verfahren seitens derer, die die Statistik erstellen. Nur in wenigen wissenschaftlichen Studien werden die Tests auch konsequent veröffentlicht.

Häufig findet man nur deskriptive Darstellungen ohne seriöse Analysen. Da werden Trendlinien gezeigt, wo es möglicherweise langfristig zyklische Ereignisse gibt. Z.B. in der Klimawissenschaft. Hier sind mehrere Zyklen bekannt, die bis über 1000 Jahre reichen können. So gab es beispielsweise eine minoische Warmzeit, eine römische Warmzeit, eine mittelalterliche Warmzeit und die aktuelle Erwärmung. Dazwischen gab es Kaltzeiten. Es liegt nahe, einen 1000-jahreszyklus anzunehmen. Die Klimawissenschaft aber produziert meist 30-jährige Trendlinien, obwohl die ozeanischen Zyklen (AMO, PDO und andere) bekannt sind, die in etwa einem 60-Jahre-Zyklus das Klima deutlich beeinflussen. Die Mittel der Statistik wären sehr wohl geeignet, hier eine sachliche Aufklärung zu liefern.

Dass die Statistik einen so schlechten Ruf hat, dennoch immer wieder unkritisch aufgenommen wird, hat weniger mit der Statistik an sich zu tun, sondern mit dem Faktum, dass man Statistik politisch missbrauchen kann und das auch tut. Selbst scheinbar seriöse Untersuchungen stehen vor der Frage, wie sie einen Sachverhalt darstellen sollen. Die Voreingenommenheit des Verantwortlichen ist nie völlig auszuschließen. Aber der seriöse Statistiker ist sich selbstkritisch seines Bias bewusst und versucht diesen eben nicht in die Auswertung einfließen zu lassen. Der Demagoge macht es anders herum. Wie sollte man Vertrauen in jene zurück gewinnen, die die Mittel der Statistik so verwenden, dass man von einem schamlosen Missbrauch ausgehen muss?

Eine Anmerkung

Übrigens: Dass wohl nicht Churchill der Urheber jenes geflügelten Wortes war, kam von einem Kommentar von Manfred Hirschkorn M. A. / 01.09.2018

Warum tun Sie es dann Goebbels gleich, der den in puncto Kriegsführung sehr genau rechnenden Churchill verunglimpfen wollte und dessen statistisch gefaßte Erfolge propagandistisch niederzumachen versuchte? Interessant ist hier auch, daß dieses „geflügelte Zitat“ – welches ja immerhin dem früheren Premierministers Großbritanniens zugeschrieben wird – in GB niemand kennt! „Goebbels Ziel war, Churchill lächerlich zu machen und ihn als Lügner vorzuführen. Auf welchen Wegen diese auf Churchill zielende spöttische Kritik in die Nachkriegspresse fand, ist derzeit noch nicht erkennbar geworden. Sämtliche befragten Verwender des „Zitats“ konnten keine Quelle benennen. Belegbar hingegen ist, daß sich Churchill in seinen Reden und Publikationen sehr positiv über die Statistik und Statistiker geäußert hat. Vertreter der britischen Statistik gehörten zu seinem engsten Beraterkreis im Kriege.“ Zitiert aus: Werner Barke, „Ich glaube nur der Statistik … Was Winston Churchill über Zahlen und Statistik gesagt haben soll – und was er wirklich sagte“, Stuttgart 2011, Herausgeber Stat. Landesamt Baden-Württemberg.